par Philippe Godet

Partager

par Philippe Godet

Partager

Améliorer le Raisonnement de l’IA avec des Techniques de Prompting Avancées

L’ingénierie du prompt est aujourd’hui au cœur de l’utilisation efficace des intelligences artificielles comme ChatGPT. Si l’on peut obtenir des résultats satisfaisants avec des instructions simples, c’est en explorant des techniques avancées, tout aussi simples, que l’on accède à tout le potentiel de ces IA. Pour terminer cette formation sur l’Art du Prompting, cette partie vous propose une exploration concrète de méthodes de prompting qui structurent le raisonnement de l’IA, des paramètres qui influencent sa réponse, et des bonnes pratiques pour documenter son travail afin d’optimiser les résultats.

Un guide essentiel pour les utilisateurs souhaitant passer de débutant à expert.

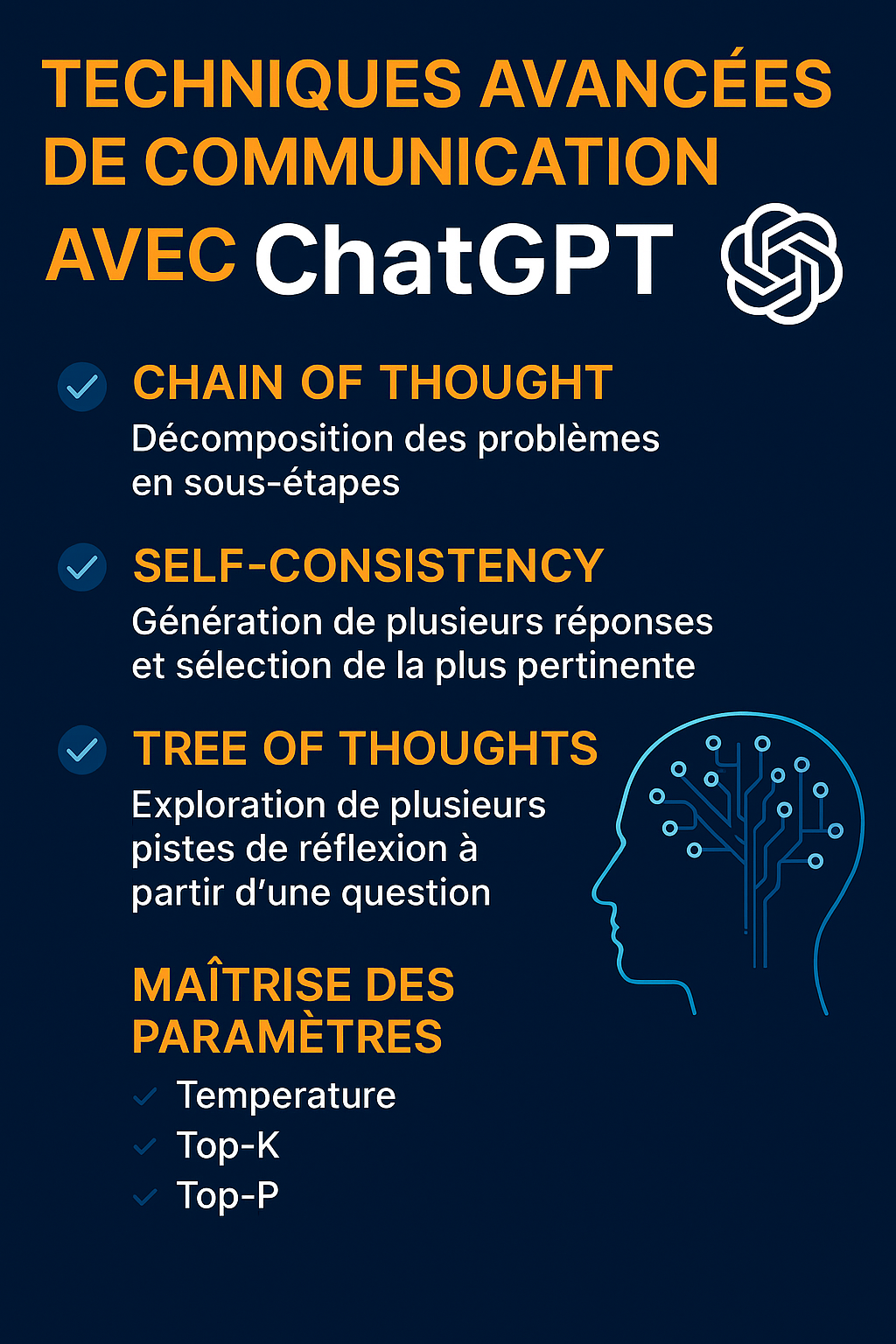

Structurer le raisonnement : techniques avancées de prompting

1. Chain of Thought (Chaîne de pensée)

Le « Chain of Thought » (CoT) est une technique qui consiste à inciter le modèle à raisonner à haute voix, en décomposant une question complexe en étapes logiques. Cela améliore significativement la qualité des réponses pour des problèmes qui nécessitent un raisonnement multi-étapes (logique, mathématique, juridique).

Exemple :

Prompt classique :

Combien de jours y a-t-il entre le 1er mars et le 15 avril ?

Avec Chain of Thought :

Réfléchis étape par étape. Combien de jours comporte le mois de mars ? Combien de jours entre le 1er mars et le 31 mars ? Ensuite, combien de jours entre le 1er avril et le 15 avril ? Additionne les deux.

Pourquoi ça fonctionne : Le modèle, plutôt que de chercher une réponse directe, se met dans une logique de déduction, comme un humain réfléchirait à voix haute.

Pour que l’IA raisonne en Chain of thought, il faut lui spécifier dans le prompt de réfléchir « étape par étape ». GPT 4

2. Tree of Thoughts (Arbre de pensées)

Le « Tree of Thoughts » pousse le raisonnement encore plus loin. Plutôt qu’une suite linéaire d’étapes, cette méthode propose plusieurs branches de réflexion, explorant différentes pistes avant de choisir la meilleure.

Exemple :

Imagine différentes manières de résoudre ce problème. Pour chaque piste, explique pourquoi elle pourrait fonctionner. Compare les options et choisis la meilleure.

Utilité : Parfait pour les problèmes ouverts ou créatifs, où plusieurs approches sont possibles : stratégies commerciales, idéation de produits, plans de résolution de conflits.

3. Self-Consistency (Auto-cohérence)

Le principe : générer plusieurs chaînes de pensées différentes pour une même question, puis comparer les réponses. La réponse majoritaire ou la plus cohérente est retenue.

Exemple :

Génère trois raisonnements distincts pour ce problème mathématique. Compare les résultats et explique la solution qui te semble la plus fiable.

Objectif : Limiter les hallucinations, réduire les erreurs logiques, améliorer la robustesse des réponses.

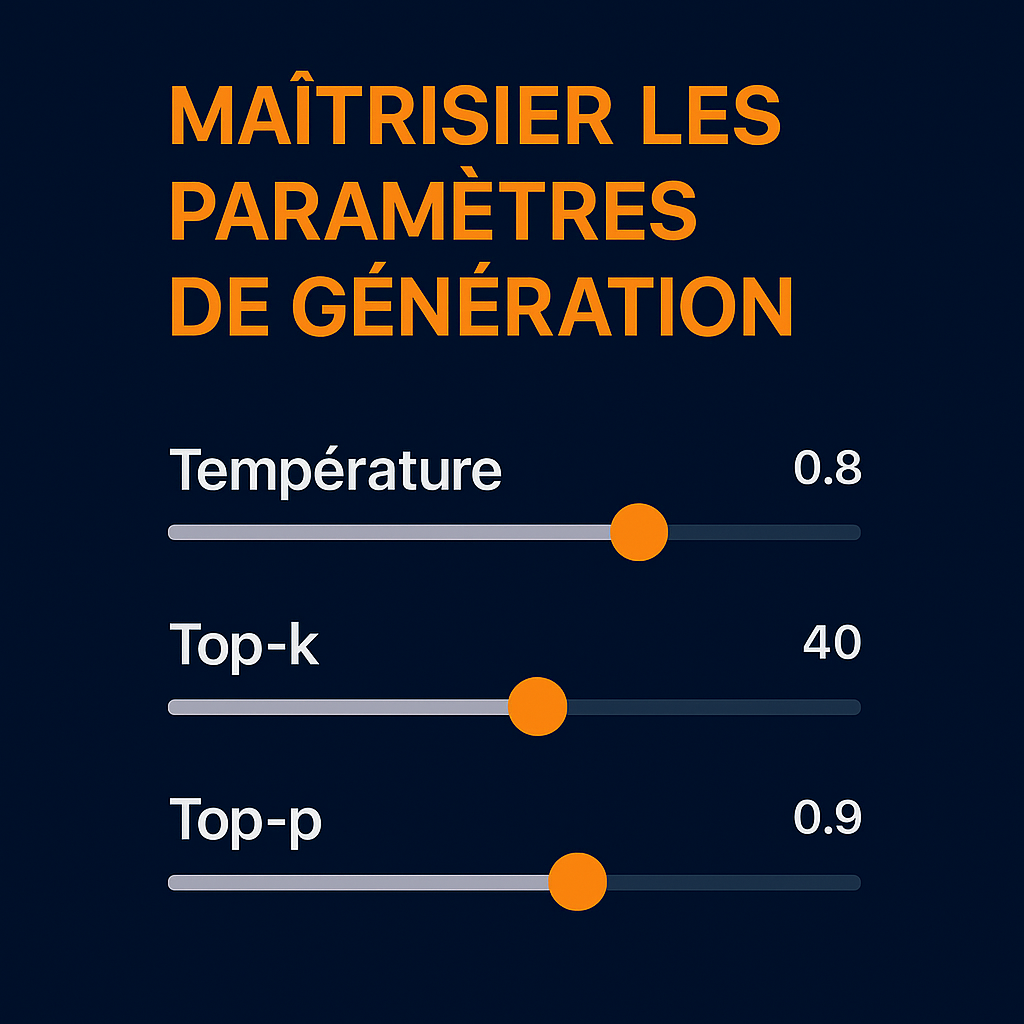

Maîtriser les paramètres de génération

Au-delà du prompt lui-même, les paramètres de génération jouent un rôle essentiel dans la qualité de la réponse produite par une IA

1. Température

Fonction : la température contrôle le niveau de hasard dans les réponses. En fonction du paramètre spécifié, elle va influer dans la réponse de l’IA sur le degré de créativité ou de précision que l’on souhaite.

Valeur entre 0 et 1 (parfois jusqu’à 2)

Température basse (ex : 0.2) : réponses plus déterministes, logiques, cohérentes.

Température haute (ex : 0.8) : plus de variété, d’originalité, utile pour la création de contenu.

2. Top-k Sampling

Fonction : au lieu de considérer tous les mots possibles, le modèle ne considère que les k mots les plus probables.

Exemple : avec k=50, il choisit dans les 50 mots les plus probables.

Avantage : réduit les dérives inattendues et le bruit.

En spécifiant un rôle à l’IA et en lui indiquant donc une base de connaissance spécifique, vous affinerez d’autant plus la réponse puisqu’elle recherchera parmi les K mots probables dans ce métier, cette activité…

3. Top-p Sampling (Nucleus Sampling)

Fonction : choisit dynamiquement un sous-ensemble de mots dont la probabilité cumulée atteint p (ex : 0.9).

Plus fluide que top-k, car adaptatif. Permet des réponses plus naturelles tout en évitant les sorties extrêmes.

Combiner les trois : Pour un contenu créatif et fluide, utilisez par exemple :

- Température : 0.7

- Top-k : 40

- Top-p : 0.9

Pour clarifier :

Top-p (Nucleus Sampling) : Cela se réfère aux tokens les plus probables en fonction de la probabilité cumulée, et non pas aux mots spécifiques. Cela limite les choix du modèle aux tokens dont la somme des probabilités atteint un certain seuil.

Max tokens : Cela détermine combien de tokens (et non de mots ou de caractères) seront générés dans la réponse. Un token ne correspond pas à un mot complet ou à un caractère ; c’est une unité de traitement plus fine. En général, un token peut être un mot court ou une partie d’un mot, mais aussi une ponctuation ou un espace.

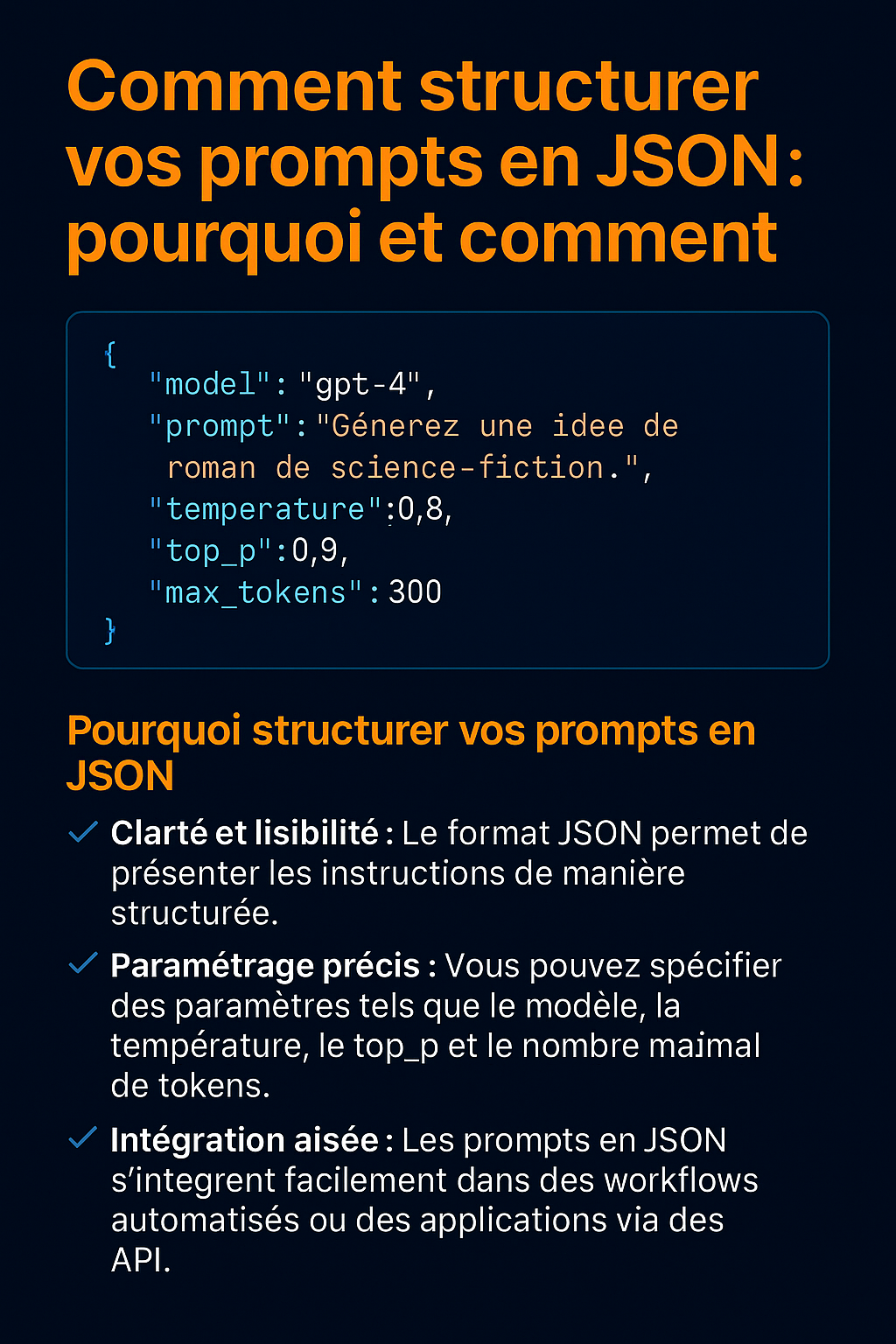

Structurer ses prompts en JSON : pourquoi et comment

Adopter le format JSON pour vos prompts avec ChatGPT offre une approche claire et organisée, particulièrement bénéfique pour les utilisateurs avancés et les développeurs.

✅ Pourquoi structurer vos prompts en JSON ?

-

Clarté et lisibilité : Le format JSON permet de présenter les instructions de manière structurée, facilitant la compréhension et la modification des prompts.

-

Paramétrage précis : Vous pouvez spécifier des paramètres tels que le modèle, la température, le top_p et le nombre maximal de tokens, offrant un contrôle fin sur la génération de texte.

-

Intégration aisée : Les prompts en JSON s’intègrent facilement dans des workflows automatisés ou des applications via des API.

🛠️ Comment structurer un prompt en JSON ?

Voici un exemple de prompt structuré en JSON :

Explication des paramètres :

-

model : Spécifie le modèle à utiliser, ici « gpt-4″.

-

prompt : Contient la demande ou la question adressée à l’IA.

-

temperature : Contrôle la créativité des réponses. Une valeur plus élevée (jusqu’à 1) rend les réponses plus variées.

-

top_p : Utilisé pour le « nucleus sampling », il limite la génération aux tokens les plus probables jusqu’à atteindre la probabilité cumulative spécifiée.

-

max_tokens : Définit la longueur maximale de la réponse générée, en nombre de tokens.

En structurant vos prompts de cette manière, vous améliorez la précision et la cohérence des réponses de ChatGPT, tout en facilitant la maintenance et l’évolution de vos interactions avec le modèle.

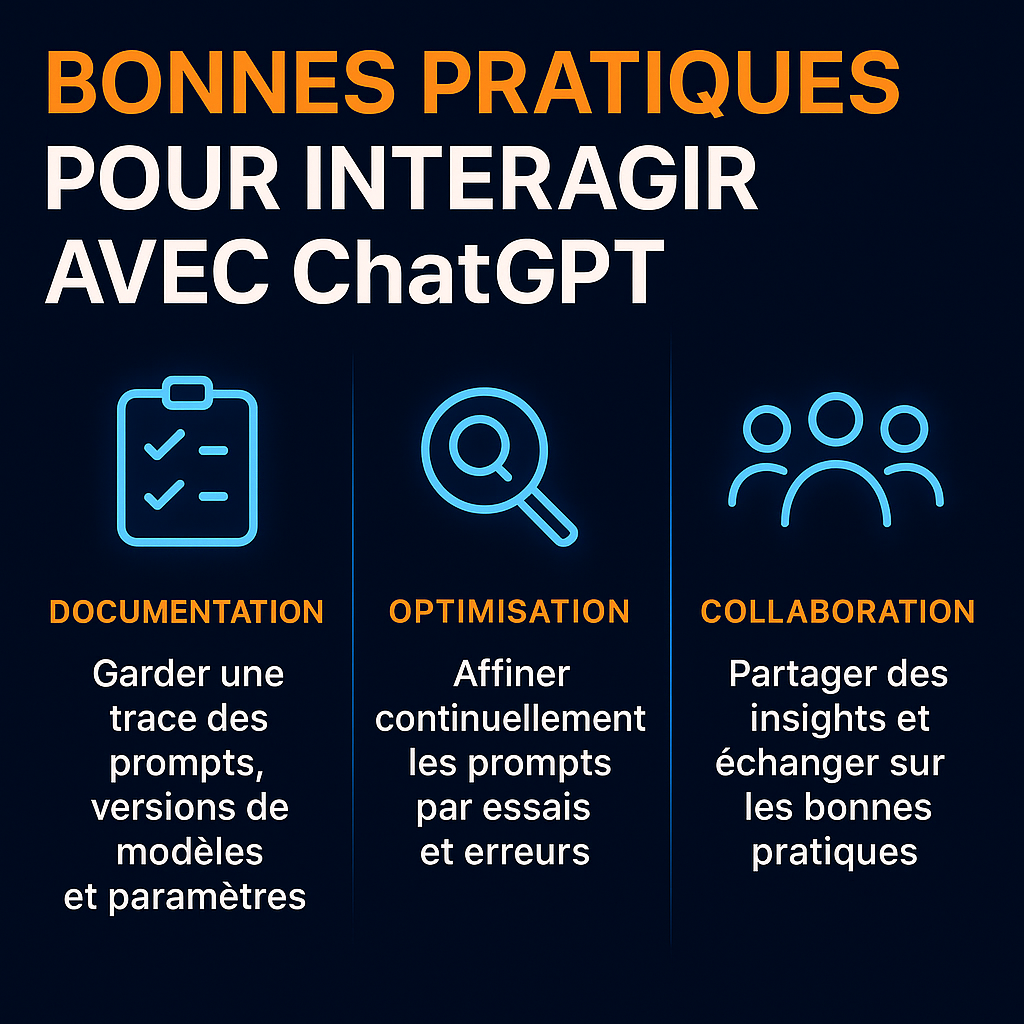

Documenter les prompts : vers une pratique professionnelle

La puissance des prompts ne réside pas uniquement dans leur forme, mais aussi dans leur traçabilité. Documenter ses requêtes devient essentiel dès lors qu’on cherche à répliquer, améliorer ou industrialiser les processus.

Pourquoi documenter ?

- Reproductibilité : retrouver le prompt exact qui a donné une bonne réponse.

- Optimisation continue : affiner un prompt en testant des variantes.

- Collaboration : permettre à une équipe de travailler ensemble efficacement.

Que documenter ?

- Le prompt exact utilisé (version finale + brouillons/test)

- Le modèle utilisé (GPT-3.5, GPT-4, Claude, etc.)

- Les paramètres de génération (temp, top-k, top-p…)

- Le contexte (objectif, données d’entrée, type de réponse attendue)

- Les résultats obtenus (bons ou mauvais)

Outils recommandés

- Notion / Obsidian : pour organiser ses tests

- Prompt engineering notebooks (Jupyter, LangChain) : pour les devs

- Fichiers JSON/YAML de prompt templates : pour une intégration automatisée

Bonnes pratiques

- Donnez un nom unique à chaque prompt

- Datez vos itérations

- Capturez les erreurs, pas seulement les succès

- Archivez les prompts non retenus avec une courte analyse

Conclusion

Le passage à une utilisation experte des IA passe par une meilleure structuration du raisonnement, un contrôle fin des paramètres de génération et une documentation rigoureuse. Les techniques comme Chain of Thought, Tree of Thoughts et Self-Consistency transforment l’IA d’un simple « répondeur » à un outil de raisonnement avancé. Maîtriser la température, le top-k et le top-p, c’est reprendre la main sur la créativité et la fiabilité. Et documenter ses prompts, c’est faire un pas vers la professionnalisation. Cette approche n’est pas seulement utile aux chercheurs ou développeurs, mais à tous ceux qui veulent tirer le meilleur parti de l’intelligence artificielle au quotidien.

Ce n’est qu’en traitant le prompting comme une véritable discipline que l’on en révèle tout le potentiel.

RESTEZ DANS LA BOUCLE