par Philippe Godet

Partager

par Philippe Godet

Partager

1. Zero-Shot Learning : Apprendre sans exemple ? Oui, c’est possible !

1.1 Qu’est-ce que le Zero-Shot Learning ?

Le Zero-Shot Learning (ZSL) désigne la capacité d’un modèle d’intelligence artificielle à accomplir une tâche sans avoir vu d’exemples spécifiques auparavant. Contrairement aux approches classiques d’apprentissage supervisé, qui nécessitent des jeux de données étiquetés pour chaque catégorie ou fonction, le Zero-Shot permet de prédire ou classer directement en s’appuyant sur des connaissances générales déjà acquises.

Un peu comme un humain qui comprend le mot « zèbre » sans en avoir jamais vu, simplement parce qu’il connaît « cheval », « rayures », et « animal africain ».

1.2 Quand l’utiliser ?

Le Zero-Shot Learning est particulièrement utile lorsque :

-

Il est impossible ou coûteux de collecter des données spécifiques (nouvelle catégorie, événement rare).

-

L’IA doit effectuer des tâches génériques comme de la classification, de la catégorisation ou de la recherche sémantique.

-

On veut tester rapidement un cas d’usage sans passer par une phase d’entraînement longue.

Exemples d’applications :

-

Filtrer des e-mails en « professionnel / personnel / spam » sans fournir d’exemples annotés.

-

Identifier la langue d’un texte sans entraîner un modèle pour chaque langue.

-

Taguer automatiquement des contenus selon des descriptions (ex. : “contenu juridique”, “promotionnel”, “à risque”).

Avantages

-

Pas besoin de jeu de données spécifique : économie de temps et de ressources.

-

Très flexible : peut s’adapter à de nouvelles classes sans réentraînement.

-

Déploiement rapide : utile pour prototyper ou tester une idée.

Limites

-

Précision parfois aléatoire : surtout si la tâche est subtile ou contextuelle.

-

Dépendance à la formulation : si les descriptions sont mal rédigées, le modèle se trompe.

-

Moins adapté aux cas complexes nécessitant de l’expertise fine.

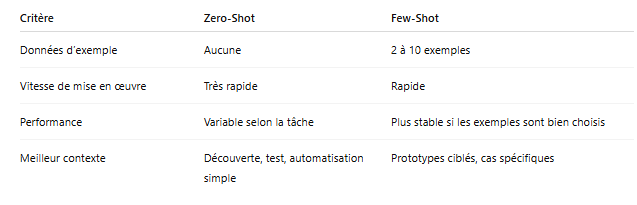

Comparaison rapide avec le Few-Shot Learning

1.3 Fine-Tuning : Quand l’IA apprend vraiment pour vous

Le Fine-Tuning (ou ajustement fin) consiste à réentraîner un modèle pré-entraîné sur vos propres données pour le spécialiser sur une tâche précise.

Imaginez un assistant vocal déjà capable de comprendre le français courant. En le fine-tunant sur des conversations médicales, vous le transformez en assistant pour cabinet de santé.

Cas d’usage concrets

-

Assistance métier personnalisée : un chatbot formé sur la documentation technique interne d’un service client.

-

Analyse documentaire : un modèle fine-tuné pour lire et extraire des données de factures, contrats, ou dossiers RH.

-

Création d’IA propriétaire : adaptée à votre secteur, vos règles, votre vocabulaire métier.

Ce qu’il faut pour fine-tuner un modèle

-

Un corpus conséquent de données annotées : au moins plusieurs centaines à plusieurs milliers d’exemples.

-

Du temps et des ressources techniques : GPU, pipelines d’entraînement, monitoring.

-

Des compétences en ingénierie IA : pour préparer les données, surveiller l’apprentissage, éviter le sur-apprentissage.

Avantages

-

Excellente précision : le modèle devient expert de vos données.

-

Fiabilité accrue : cohérence dans les réponses, respect du ton ou des formats.

-

Contrôle : vous pouvez corriger ou orienter le modèle comme bon vous semble.

Limites

-

Long à mettre en œuvre : plusieurs jours voire semaines.

-

Coûteux : en temps, en données, en puissance de calcul.

-

Peu flexible : un modèle fine-tuné sur une tâche ne peut pas facilement être réutilisé ailleurs.

Quand l’éviter

-

Vous n’avez pas suffisamment de données de qualité.

-

Vous voulez tester un usage rapidement : privilégiez alors le Zero-Shot ou le Few-Shot.

-

Vous n’avez pas encore validé le besoin métier.

1.4 Few-Shot vs Fine-Tuning vs Zero-Shot : Quelle méthode choisir ?

1.5 Recommandations par contexte

-

Découverte, test rapide : ➜ Zero-Shot

-

Prototypage rapide, cas concret : ➜ Few-Shot

-

Déploiement stable sur une tâche métier : ➜ Fine-Tuning

Métaphore simple

Zero-Shot = poser une question à quelqu’un qui a lu beaucoup de livres mais ne connaît pas votre cas.

Few-Shot = lui donner quelques exemples avant de lui poser la question.

Fine-Tuning = lui faire une vraie formation spécifique avant de lui poser des questions.

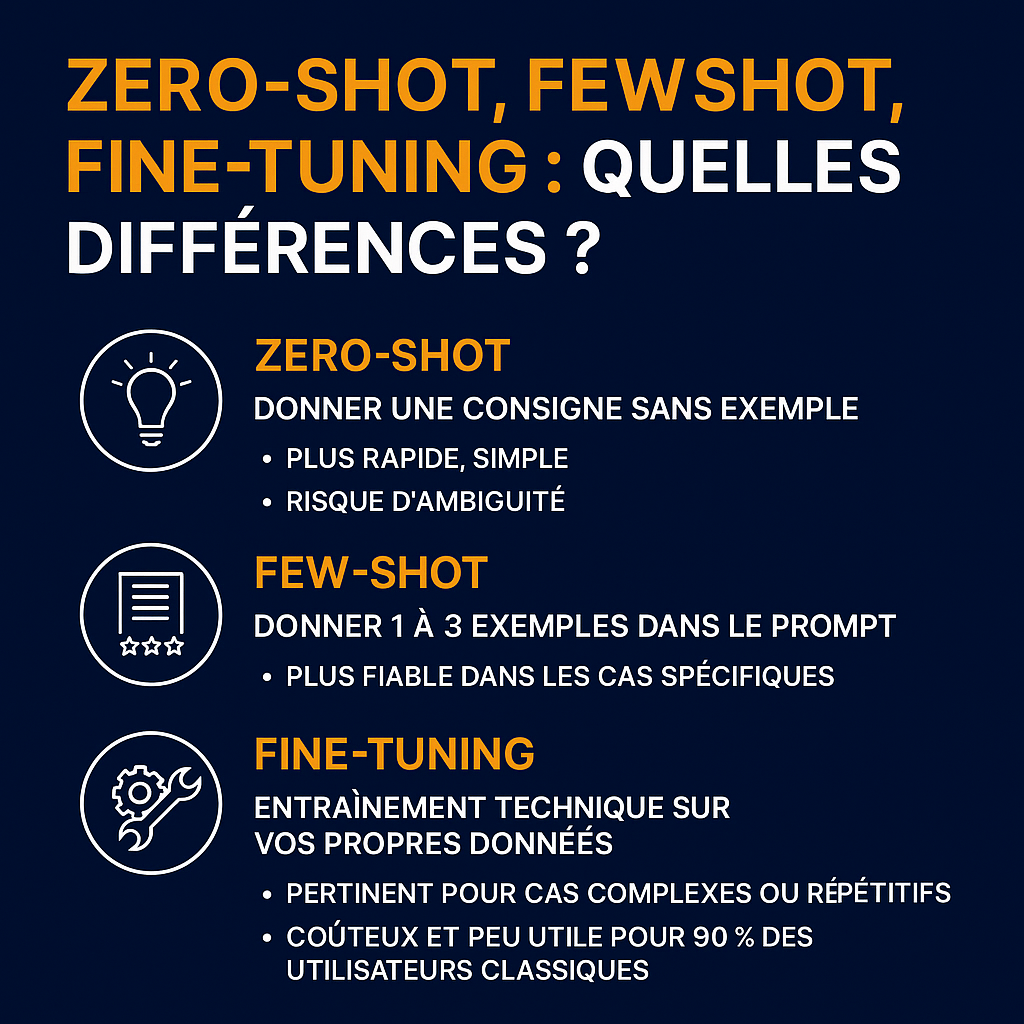

🧠 Points clés

Zero-shot, Few-shot, Fine-tuning : quelles différences ?

-

Zero-shot = donner une consigne sans exemple

-

Plus rapide, simple

-

Risque d’ambiguïté

-

-

Few-shot = donner 1 à 3 exemples dans le prompt

-

ChatGPT imite le modèle des exemples

-

Plus fiable dans les cas spécifiques

-

-

Fine-tuning = entraînement technique sur vos propres données

-

Nécessite des compétences techniques

-

Pertinent pour cas complexes ou répétitifs

-

Coûteux et peu utile dans 90 % des cas pour un utilisateur classique

-

-

Pour la majorité des utilisateurs, le few-shot est la meilleure stratégie

-

Pas besoin de coder

-

Meilleurs résultats que le zéro-shot

-

✅ Activité – Construire un prompt en few-shot

Objectif :

Apprendre à structurer un prompt à partir de 2 ou 3 exemples

Étapes :

-

Donnez une consigne simple : « Résume ce texte en une phrase »

-

Fournissez 2 exemples de texte + leur résumé

-

Ajoutez un nouveau texte à résumer

-

Comparez la qualité de la réponse obtenue en mode few-shot vs zero-shot

Durée estimée : 10–15 minutes

RESTEZ DANS LA BOUCLE