par Philippe Godet

Partager

par Philippe Godet

Partager

L’art de généraliser à partir de trois exemples

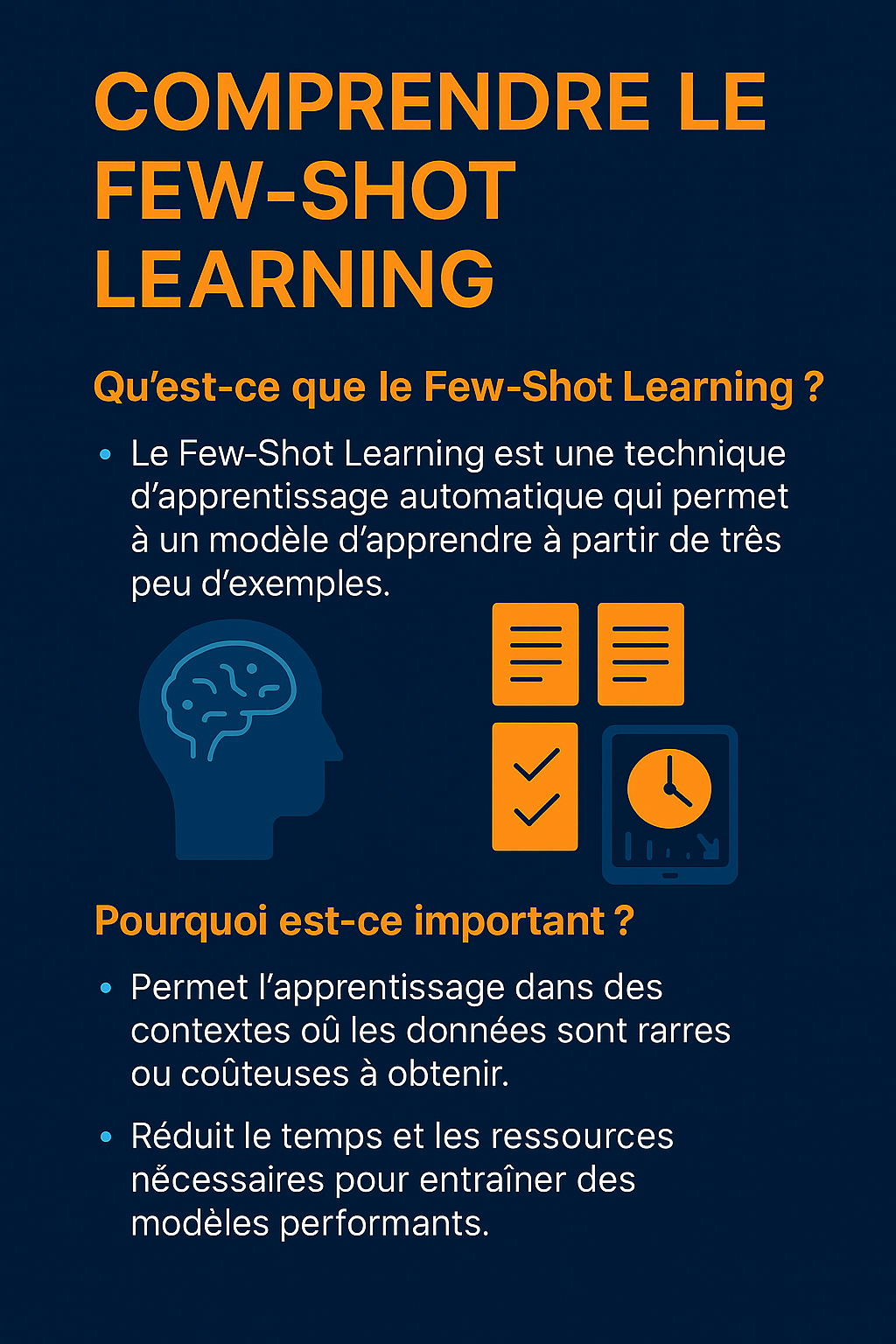

Dans beaucoup de domaines, il est difficile de rassembler de grandes quantités de données. Par exemple : détecter des maladies rares, traiter des dialectes locaux ou analyser des documents confidentiels. Dans ces cas-là, les méthodes classiques d’entraînement de l’intelligence artificielle (IA) échouent, car elles nécessitent un volume de données qu’on ne peut pas toujours obtenir.

C’est là qu’intervient le few-shot learning (FSL), ou « apprentissage à partir de quelques exemples ».

Cette méthode permet à un modèle (comme ChatGPT) d’apprendre à résoudre une tâche spécifique en recevant seulement quelques exemples bien choisis.

Cela change tout : on peut créer un prototype ou tester une idée en quelques heures au lieu de plusieurs mois.

1. Principes fondamentaux

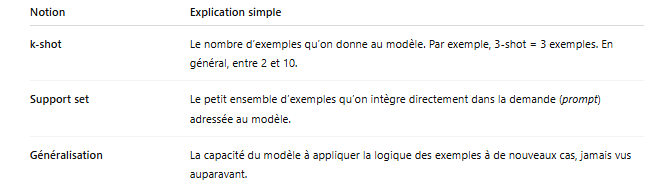

Pour bien comprendre le few-shot learning, voici trois notions clés :

Pourquoi cela fonctionne-t-il ? Parce que le modèle a déjà été pré-entraîné sur d’immenses bases de textes ou d’images. Il possède donc une sorte de culture générale implicite. Les quelques exemples que vous fournissez servent à activer la bonne « zone » de sa mémoire.

2. Bien choisir ses exemples (et éviter les pièges)

Utiliser le few-shot learning, ce n’est pas juste donner trois phrases au hasard. Il faut sélectionner les bons exemples pour guider le modèle efficacement. Voici comment faire :

Représentativité

Vos exemples doivent couvrir toutes les situations que vous ciblez.

Par exemple, si vous voulez que l’IA classe des avis clients positifs et négatifs en français et en anglais, il faut prévoir au moins un exemple positif en français, un négatif en français, un positif en anglais et un négatif en anglais.

Unicité

Évitez de répéter la même idée sous des formes différentes. Si vous donnez plusieurs fois le même type d’exemple, cela occupe inutilement de l’espace sans améliorer les performances.

Cohérence stylistique

Vos exemples doivent avoir le même style : même ton (familier ou soutenu), même langue (évitez de mélanger français et anglais), même mise en forme (par exemple, majuscule systématique en début de phrase).

Budget de longueur (prompt length budget)

Attention : les modèles ont une limite de longueur (par exemple, ≈ 8 000 mots pour GPT-4). Si votre prompt est trop long, il sera coupé, et le modèle manquera d’informations clés.

3. Workflow (méthode pas à pas)

Voici une méthode simple pour construire un bon prompt few-shot :

Définir la tâche

Posez-vous la question : que dois-je demander au modèle ?

Exemple : « Classer des phrases en POSITIF ou NÉGATIF. »

Choisir les bons exemples (k-shot)

Prenez entre 2 et 10 exemples, en veillant à couvrir toutes les combinaisons importantes (par exemple, différentes langues et polarités).

Construire le prompt

-

Donnez un contexte clair : « Vous êtes un modèle qui classe des avis clients en POSITIF ou NÉGATIF. »

-

Ajoutez le support set (vos exemples étiquetés).

-

Formulez une instruction explicite : « Indiquez uniquement POS ou NEG en réponse. »

Évaluer rapidement

Testez le prompt avec une petite série de cas (ex. : 20 phrases inédites) et vérifiez manuellement si les réponses sont correctes.

Améliorer par itérations

Repérez les exemples qui n’apportent pas d’information utile ou qui perturbent le comportement du modèle. Remplacez-les, puis testez à nouveau.

4. Étude de cas (exemple concret)

Imaginons que vous travailliez sur un assistant marketing pour générer des slogans pour une confiture bio.

-

Tâche : créer des slogans chaleureux et courts (6 à 8 mots).

-

Support set : vous fournissez 5 slogans existants, comme :

« Un goût authentique, tout simplement bio »

« La nature à tartiner chaque matin » -

Résultat : après test, 89 % des slogans générés sont jugés pertinents par un panel de 45 personnes.

-

Amélioration : vous ajoutez un exemple plus poétique

(« Une caresse de fruits sur vos tartines ») pour enrichir la variété stylistique.

→ Résultat après test : 92 % de pertinence perçue.

Conclusion : parfois, un seul exemple bien choisi peut faire toute la différence.

Conclusion

Le few-shot learning est une méthode puissante pour entraîner un modèle à réaliser des tâches spécifiques même en l’absence de grandes bases de données.

Ce qui compte, ce n’est pas la quantité d’exemples, mais leur qualité, leur pertinence, et leur capacité à représenter les cas d’usage importants.

Avec une bonne sélection et une démarche itérative, on peut obtenir des résultats très satisfaisants, même dans des contextes complexes.

🧠 Points clés

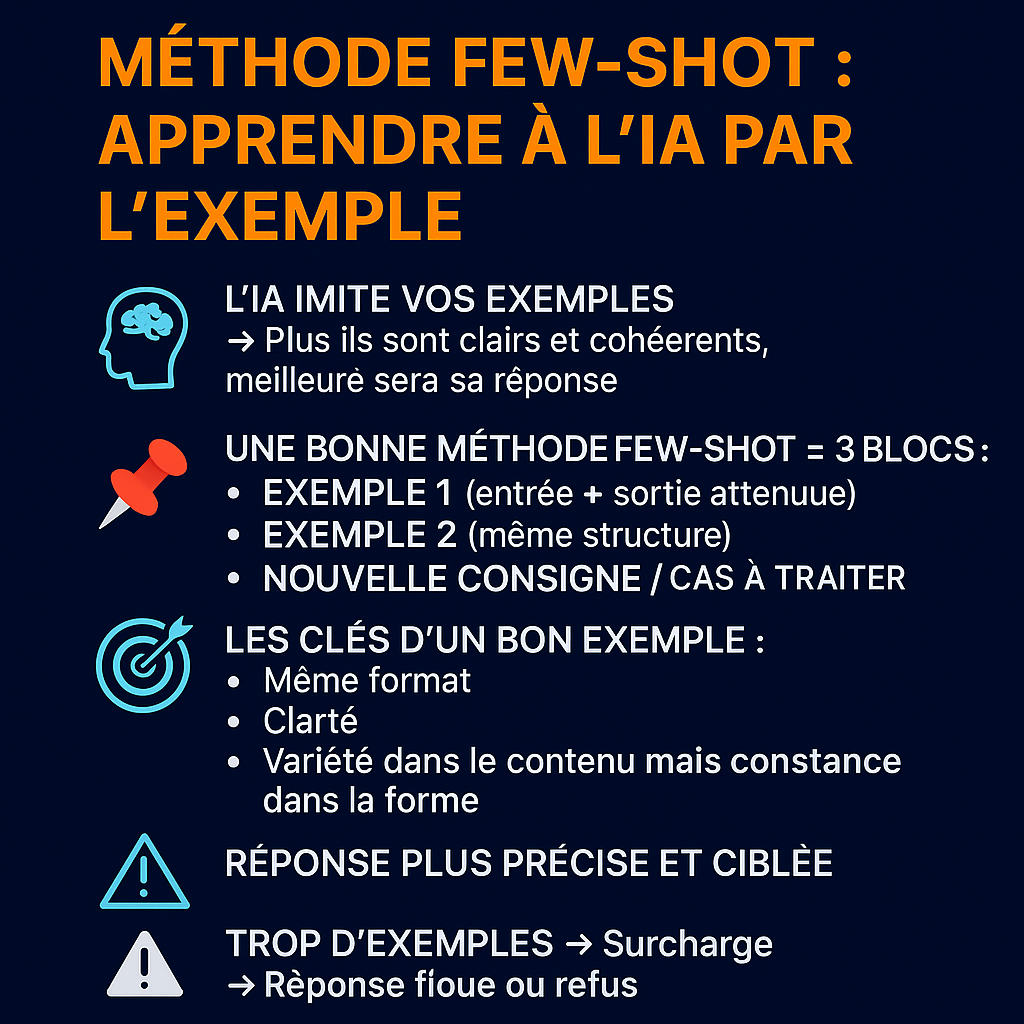

Méthode Few-Shot : apprendre à l’IA par l’exemple

-

🧠 L’IA imite vos exemples

→ Plus ils sont clairs et cohérents, meilleure sera sa réponse -

📌 Une bonne méthode few-shot = 3 blocs :

-

Exemple 1 (entrée + sortie attendue)

-

Exemple 2 (même structure)

-

Nouvelle consigne / cas à traiter

-

-

🎯 Les clés d’un bon exemple :

-

Même format

-

Clarté

-

Variété dans le contenu mais constance dans la forme

-

-

✅ Résultat : réponse plus précise et ciblée

-

⚠️ Trop d’exemples → surcharge → réponse floue ou refus

✅ Activité – Construire un prompt few-shot

Objectif :

Structurer un prompt en 3 étapes avec des exemples concrets

Étapes :

-

Choisissez une tâche simple (ex. : transformer une phrase familière en phrase professionnelle)

-

Rédigez 2 exemples :

-

Entrée familière → sortie professionnelle

-

-

Ajoutez un 3ᵉ cas à traiter par l’IA

-

Comparez la réponse avec un prompt sans exemples (zero-shot)

Durée estimée : 10–12 minutes

RESTEZ DANS LA BOUCLE