par Philippe Godet

Partager

par Philippe Godet

Partager

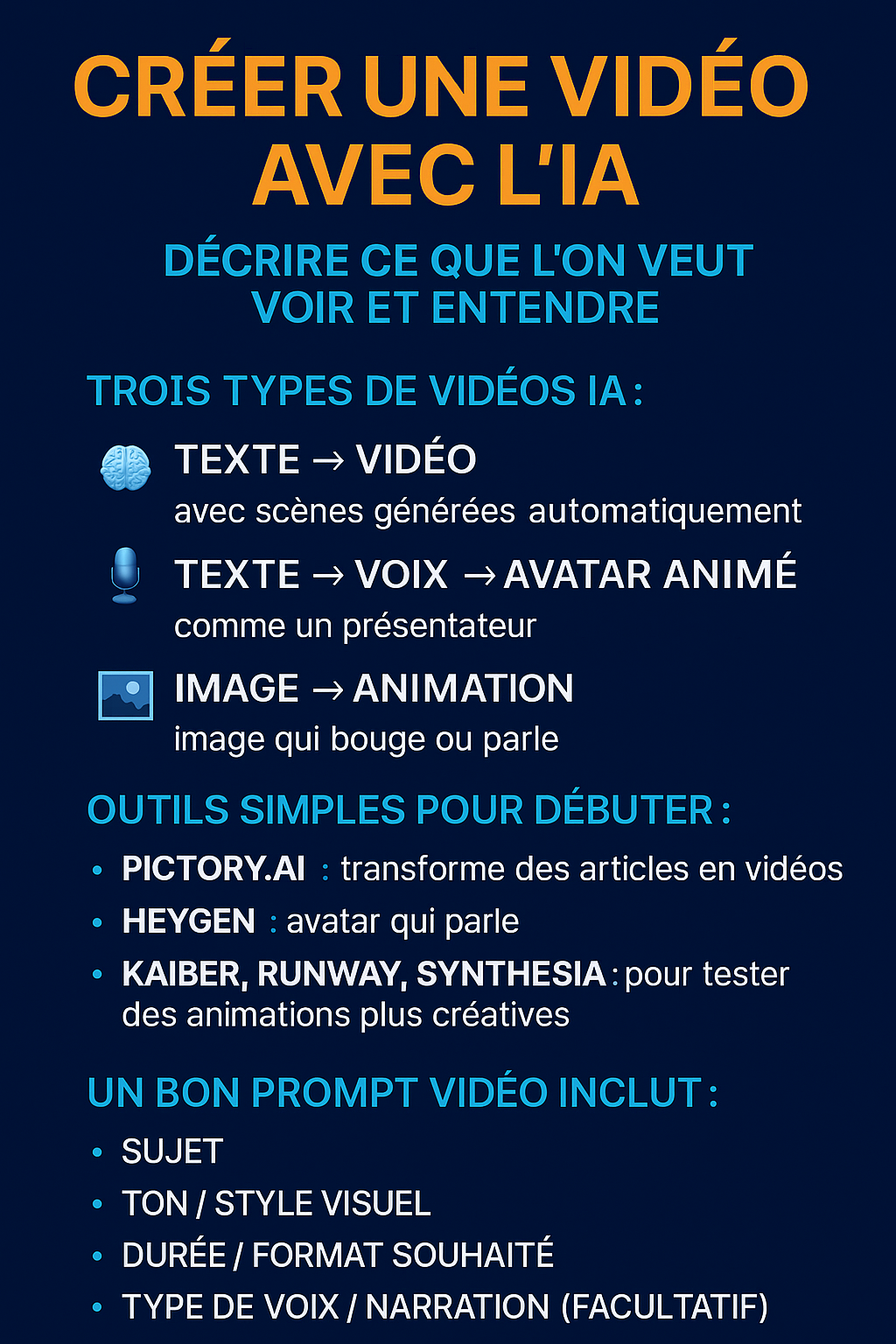

Pourquoi se lancer dans la vidéo générative ?

Les chiffres 2025 sont sans appel : les formats vidéo courts (< 30 s) génèrent en moyenne 54 % d’engagement supplémentaire par rapport aux visuels statiques sur les réseaux sociaux. Longtemps réservée aux studios équipés de GPU onéreux, la création vidéo assistée par IA s’est démocratisée grâce à :

- L’arrivée de modèles « text‑to‑video » (Sora, Veo 3, Gen‑3…) accessibles via une interface web ou une API.

- Des coûts en forte baisse : quelques centimes pour 10 secondes en 1080 p, contre plusieurs dollars en 2023.

- Une prise en main no‑code : rédiger un prompt revient à écrire une mini‑description de scénario.

Pour un créateur de contenu, un service marketing ou une équipe pédagogique, cela signifie :

- Prototyper une idée de clip en quelques minutes pour valider un concept ou un storyboard.

- Automatiser la production de visuels animés (stories, teasers, bandes annonces, posts pédagogiques).

- Réduire les coûts de tournage, de motion design et d’achat de banque d’images.

1. Les coulisses du text‑to‑video expliquées simplement

Lorsque vous saisissez :

“Travelling avant sur un robot barista servant un café au ralenti, ambiance néon, clip 12 s”

voici ce qu’il se passe « sous le capot » :

1 Parsing & tokenisation : votre texte est découpé en tokens puis projeté dans un espace sémantique (embeddings) afin que le modèle comprenne les concepts (robot, barista, néon…).

2 Conditionnement spatio‑temporel : le réseau compile ces embeddings pour guider une diffusion latente 3D – imaginez la génération d’images clés (keyframes) placées à différents instants.

3 Propagation temporelle : un module de cohérence fait le lien entre les frames pour que les objets restent stables (le café coule de haut en bas, la tasse ne change pas de forme…).

4 Super‑résolution (SR) : un second réseau affine chaque image, augmente la résolution (par ex. 720 p → 4 K) et supprime les artefacts.

5 Post‑traitement : stabilisation, anti‑flicker, ajout éventuel de filigrane (watermark SynthID) pour prouver l’origine IA.

Résultat : un fichier MP4 ou MOV de 5 à 60 s — selon le fournisseur et la puissance GPU engagée.

2. Tour d’horizon des modèles leaders (juin 2025)

2.1 Sora (OpenAI)

- Durée : 10 s max (API ou interface web)

- Résolutions : jusqu’à 2048 × 2048, ratio libre

- Forces : cohérence physique exceptionnelle, gestion des particules (eau, poussière), capacité à interpréter des scénarios complexes.

- Limites : accès limité (wait‑list), coût unitaire élevé (~0,30 $ pour 10 s en 1080 p).

2.2 Veo 3 (Google DeepMind)

- Durée : 60 s, orientation storytelling long format

- Singularité : pilotage caméra (zoom, travelling) directement dans le prompt : “smooth dolly zoom in”.

- Bon à savoir : file d’attente importante aux heures de pointe ; recommande un prompt < 400 tokens.

2.3 Runway Gen‑3 Alpha

- Public : créateurs no‑code via interface web.

- Plus : intégration audio (bibliothèque libre de droits), éditeur timeline intégré.

- Moins : style graphique parfois « Runway‑esque », moins réaliste que Sora.

2.4 Pika 1.2

- Positionnement : remix et extension vidéo (video‑to‑video) ; idéal pour transformer un GIF ou photo en animation.

- Limite : visages encore perfectibles ; nécessite souvent un upscale externe.

2.5 Luma Dream Machine

- Force : sortie en 4 K natif, rendu photoréaliste.

- Limite : durée courte (5 s). Parfait pour boucles ou logos animés.

Choisissez donc votre modèle selon trois critères : durée souhaitée, style (réaliste vs stylisé) et résolution finale.

3. Maîtriser l’art du prompt vidéo

Un bon prompt vidéo répond aux questions : Qui ? Où ? Quoi ? Comment ? Combien ?. Pour mémoriser, utilisez la méthode C.A.M. :

| Élément | Questions clés | Exemple |

|---|---|---|

| Contexte | Où se déroule la scène ? Quelle ambiance ? | Ruelle cyberpunk pluvieuse, éclairage néon violet. |

| Action | Quel mouvement principal ? Qui fait quoi ? | Caméra en travelling arrière dévoilant un robot musicien jouant du saxophone. |

| Média | Durée, format, bande‑son, ratio ? | Clip 8 s, 1080 p 16:9, bruit de pluie léger, jazz downtempo. |

Exemple de construction pas‑à‑pas

- Idée brute : « Un drone survole un vignoble au lever du soleil. »

- Ajout Contexte : “Golden hour, légère brume automnale, vignoble toscan”.

- Ajout Action : “Mouvement ascendant puis pivot à 180° révélant une villa en pierre.”

- Ajout Média : “Durée 12 s, 4 K, musique acoustique douce”.

Prompt final :

L’heure dorée au-dessus d’un vignoble toscan brumeux. Prise de vue par drone en ascension puis panoramique à 180 degrés pour révéler une villa rustique en pierre, clip de 12 secondes, 4K, fond de guitare acoustique.

4. Workflow détaillé — du storyboard à la publication

Étape 1 – Storyboard express (5 mn)

Dessinez ou décrivez en trois phases l’ouverture, l’action clé, la conclusion. Cet effort explicitera votre prompt et évitera les omissions incohérentes.

Étape 2 – Rédaction du prompt (Méthode C.A.M.)

Validez que chaque critère (contexte, action, média) apparaît clairement. Limitez‑vous à 2‑3 phrases pour rester sous le seuil optimal (≈ 300 tokens).

Étape 3 – Génération

Choisissez le modèle → collez votre prompt → lancez la tâche. Sur Sora, privilégiez num_frames = 24 fps × durée pour une fluidité naturelle.

Étape 4 – Upscale & stabilisation

Si la plateforme ne propose pas de super‑résolution native :

- Passez par Topaz Video AI (mode Proteus) pour un upscale 4 K + débruitage.

- Ou utilisez Runway Enhance pour corriger le flicker frame‑to‑frame.

Étape 5 – Ajout audio

- Transcription : Whisper v3 pour générer un script sous‑titré multilingue.

- Voix synthétique : ElevenLabs v2 (32 langues) ou Google Wavenet.

- Mixage dans CapCut ou Adobe Premiere Rush.

Étape 6 – Publication & watermark

Intégrez votre logo ou le filigrane SynthID pour indiquer l’origine IA — une exigence croissante avec l’AI Act 2024/1689.

5. Prompts d’inspiration commentés

5.1 Teaser produit (montre connectée)

Prise de vue macro en studio, montre intelligente tournant lentement sous une lumière de bord dramatique, boucle de 8 secondes, 60 fps, fond noir, bande son techno minimale.

Pourquoi ça marche ? Le décor neutre met en valeur l’objet, « boucle » évoque une animation continue pour réseaux sociaux.

5.2 Vidéo pédagogique (maths niveau collège)

Tableau blanc animé, expliquant le théorème de Pythagore étape par étape, texte manuscrit, 30 secondes d’explication, voix off féminine sympathique.

Clé : Le style “Tableau blanc animé” guide le moteur vers un rendu 2D clair.

5.3 Pub réseau social (soldes d’été)

Mouvement typographique énergique, texte en néon « Soldes d’été – 50 % », clip de 5 secondes, rythme EDM, effet de bougé de caméra.

Ici : la brièveté + l’appel textuel capitalisent sur la mémoire visuelle du spectateur.

6. Bonnes pratiques et pièges à éviter

- Durée ≤ 15 s pour limiter les artefacts et les coûts GPU.

- Syntaxe simple : virgules + phrases courtes pour aider le modèle à séquencer les actions.

- Évitez les contradictions : “style réaliste animé” mélange deux genres — choisissez l’un ou l’autre.

- Respect des droits : vérifiez que la licence du modèle couvre un usage commercial ; sinon, rachetez les droits audio/visuels nécessaires.

- Éthique : pas de deep‑fake sans consentement explicite ; mentionnez l’origine IA auprès de votre audience.

7. Éco‑responsabilité — combien consomme votre clip ?

La consommation énergétique dépend essentiellement de la résolution et de la durée :

| Paramètre | 720 p 12 s | 1080 p 12 s | 4 K 12 s |

| Consommation moyenne* | 0,18 kWh | 0,32 kWh | 0,75 kWh |

*Estimation sur GPU A100, taille du lot = 1.

Réduire la durée de 12 → 8 s permet d’économiser ~33 % d’énergie.

8. Checklist finale « Vidéo IA réussie »

• Storyboard validé (3 à 5 cases)

• Modèle choisi selon durée/résolution

• Prompt C.A.M. clair et cohérent

• Upscale ou stabilisation appliqués au besoin

• Bande son ou voix off intégrées

• Watermark/logo ajouté + vérification droits

- Documentation Sora (developer preview) : guides, quotas, exemples JSON.

- Google Veo 3 I/O (l’outil video de Google) :

- Runway Academy – Gen‑3 Creative Strategies (cours gratuit).

- Luma AI Discord : channel #dream‑machine‑prompts pour partager et commenter vos essais.

Vous voilà prêt à créer et partager vos premiers clips génératifs !

✅ Activité – Scénariser une vidéo IA

Objectif :

Créer un script + brief vidéo IA à tester dans un outil simple. Affinez.

Exemple :

« Rédige une vidéo d’une minute qui explique les bienfaits du sommeil, style professionnel, ton bienveillant, format vertical pour réseaux sociaux. »

Durée estimée : 15 minute

RESTEZ DANS LA BOUCLE

Actualité digitale et Formations Marketing & Vente

Laisser un commentaire

Cela fait près d’un an qu’Open AI repousse le lancement de ChatGPT 5, une nouvelle révolution dans l’IA. La plupart des spécialistes tablent sur un lancement cet automne et Open AI semble préparer le terrain en introduisant la fonctionnalité « Agent ». ChatGPT-5 : La Révolution de l’IA vers l’Action Dans le monde en constante évolution de […]

Le mode d’emploi pas-à-pas pour lancer un script… sans devenir programmeur Si vous souhaitez faire travailler votre IA sur un projet complexe comme par exemple la compilation d’un volume important de données sur une mlultitude de fichier, il est possible que celle-ci ne soit pas en mesure de le faire. Elle va commencer le travail, […]